구글 코랩에서 코드를 돌리려 했는데 과금을 안 해서 실행이 불가했다..

이를 해결하기 위해 로컬로 돌리기로 했다.

그런데 cuda 환경이 충돌이 났다

내 컴퓨터에 설치된 쿠다는 11.2인데 필요한 쿠다 버전은 12 이상이다.

쿠다 버전을 12 이상 사용하려면 도커를 사용해야 했다.

12.6 도커 이미지를 다운 받았다.

https://hub.docker.com/r/nvidia/cuda/tags

https://hub.docker.com/r/nvidia/cuda/tags

hub.docker.com

여기서 이미지를 다운 받으면 된다.

이미지가 깔린것을 확인하면 컨테이너를 만들자

docker run --gpus all -it -v C:\Users\min20\coding\fine-tuning:/root/workspace nvidia/cuda:12.6.0-cudnn-devel-ubuntu20.04 /bin/bash

해당 명령어를 사용해서 컨테이너를 만들었다.

내가 사용할 파일이 있는 디렉토리를 /root/workspace라는 디렉토리로 복사할 수 있다.

위 명령을 통해 컨테이너에 들어와서 실행한 사진이다.

/ 에서 cd root로 /root 디렉토리에 들어오면 workspace라는 새로운 디렉토리가 생겼고

그 아래에 내가 기존에 vs code에서 작업하던 파일들이 존재한다.

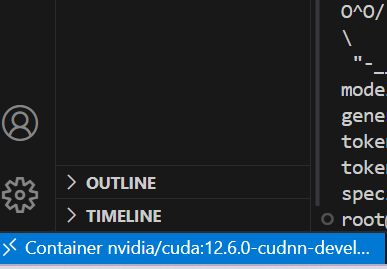

여기서 도커에서 실행중인 컨테이너를 attatch를 이용해서 새 vs code 창을 연다.

하단이 이렇게 도커 위에서 실행됨을 알 수 있다.

이제 여기서 python3, pip, git 등을 설치해 줘야한다.

파이썬은 3.11 버전을 지정해서 설치했다.

나는 쿠다를

pip install torch==2.3.1 torchvision==0.18.1 torchaudio==2.3.1 --index-url https://download.pytorch.org/whl/cu121

https://download.pytorch.org/whl/cu121

download.pytorch.org

로 설치했다.

https://colab.research.google.com/drive/1jwGg8_UWvj6KwSAklhcuVWOwmm6OFb18#scrollTo=pCqnaKmlO1U9

2번. (필로소피 AI 교육) Llama-3.1 8b + Unsloth 2x faster finetuning3.ipynb

Colab notebook

colab.research.google.com

코드는 위 코드를 참고했다.

유튜버분이 만드신 라마 파인튜닝 자료이다.

'도커' 카테고리의 다른 글

| mySQL 서버 도커로 실행하기 (0) | 2024.11.15 |

|---|---|

| 도커 허브에서 우분투를 받아 실행해보기 (0) | 2024.11.15 |

| 도커 이미지 만들고 hub에 올리기, 올린 도커 이미지 받아서 실행해보기 (0) | 2024.11.15 |

| 도커 이미지와 컨테이너 알아보기 (0) | 2024.09.01 |

| 도커에 쿠다 설치 (0) | 2024.08.31 |